Tests en conditions réelles : théorie vs pratique

Après la théorie, place à la pratique. L’article précédent a décortiqué l’architecture de Nano Banana et ses limites techniques. Maintenant, voyons ce que ça donne vraiment : Banksy, yachts, voyages temporels… et quelques surprises au passage. Chaque test ci-dessous révèle un aspect concret du modèle.

Les expérimentations ci-dessous ont été réalisées avec Nano Banana (Gemini 2.5 Flash Image). Depuis le 20 novembre 2025, Nano Banana Pro (Gemini 3 Pro Image) corrige plusieurs des limites observées dans ces tests (Test 5 “vendu” fonctionne maintenant. Ces tests restent pertinents pour comprendre l’évolution du modèle et les défis réels de l’IA visuelle en conditions d’usage.

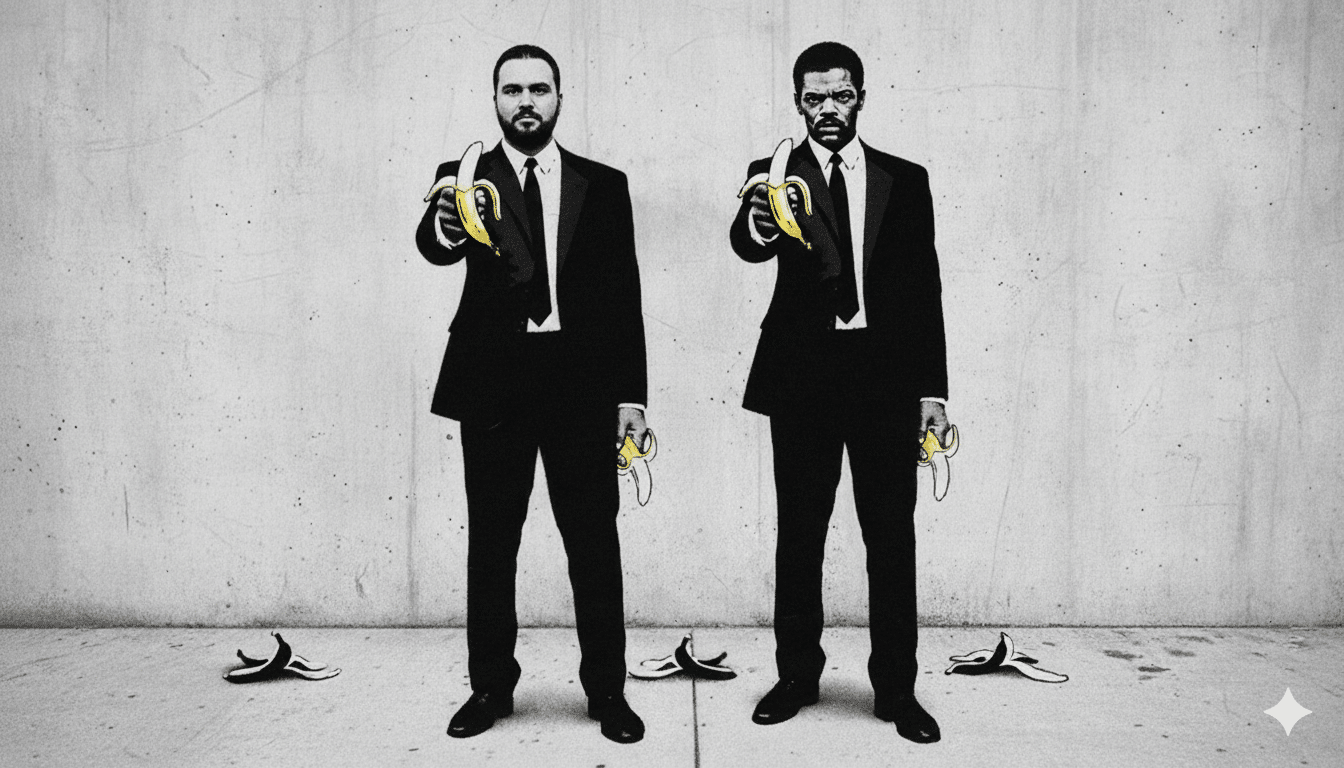

Test 1 : Character consistency et compréhension culturelle

Objectif : Tester l’embedding de visage et la compréhension des références culturelles.

Prompt : “Put me in the Banksy Pulp Fiction image instead of John Travolta.”

Image upload : Une photo de bureau standard.

Résultat v1 : Le modèle recrée l’œuvre emblématique de Banksy (deux personnages en costumes noirs brandissant des bananes comme des flingues, esthétique pochoir noir et blanc) en remplaçant le visage de John Travolta par le mien, tout en gardant Samuel L. Jackson intact.

Ce que ça démontre : Le modèle a compris plusieurs choses sans précision :

- Quelle œuvre de Banksy j’évoquais

- Quel personnage était John Travolta (celui de gauche)

- Qu’il devait garder l’autre personnage intact

- Le style pochoir/street art à respecter

- Les bananes iconiques à conserver

Mon visage est parfaitement reconnaissable, mais un détail cloche : des reflets lumineux sur ma tête, hérités de l’éclairage de ma photo originale. La taille de la tête semble légèrement disproportionnée.

Itération v2 : “Remove the lights on the left person’s head. Adjust the head size to match the body and align the style with the right person.”

Style plus homogène, proportions corrigées, pas de reflets parasites. Mais mon visage est légèrement moins reconnaissable. En uniformisant le style pochoir, l’IA a lissé certains traits distinctifs.

Concept illustré : Le trade-off cohérence/diversité expliqué en section 3. Le modèle a dû choisir entre fidélité à mes traits et fidélité au style Banksy. C’est un problème d’optimisation sous contraintes : il n’y a pas toujours de solution parfaite.

Test 2 : Édition itérative multi-tours et contexte persistant

Objectif : Tester le mécanisme d’attention temporel et la mémoire conversationnelle.

Phase 1 : Création de l’asset

J’uploade le logo de Daveo.

Prompt : “Create an energy drink can with this logo.”

Résultat : Une canette bleu foncé avec le logo Daveo intégré, condensation réaliste, reflets métalliques.

Phase 2 : Intégration dans une scène

J’uploade la canette créée, une photo de référence de style (homme en chemise blanche sur yacht), et ma photo.

Prompt : “Put me on a yacht with this style, leaning on the railing, drinking from the can.”

Résultat : Me voilà sur un pont de yacht au coucher du soleil, chemise blanche à motifs dorés, canette Daveo à la main.

Phase 3 : Le bug devenu feature

Prompt : “Show me from different camera angles on the boat.”

Résultat inattendu : Le modèle m’a cloné au lieu de changer d’angle de caméra.

Phase 4 : Bar final

Prompt : “Put us around a bar with my company logo and drinks.”

Résultat : Deux versions de moi autour d’un bar de yacht, logo Daveo en arrière-plan, plusieurs canettes sur le comptoir.

Concepts illustrés :

- L’encoding hiérarchique : La canette conserve ses proportions à travers les scènes

- Le contexte persistant : Le modèle garde en mémoire les éléments des générations précédentes

- Le multi-image fusion : Trois inputs (ma photo, style référence, canette) fusionnés en une scène cohérente

L’interprétation créative : “Different views” a été compris comme “plusieurs personnes” plutôt que “plusieurs angles”

Test 3 : Transformation de style et character consistency

Sous son nom de smoothie tropical, Nano Banana (Gemini 2.5 Flash Image) cache une architecture sérieuse : un modèle multimodal qui fusionne texte et image dès l’entrée du pipeline, et non comme deux flux séparés qu’on recolle après coup. C’est cette conception “native multimodale” qui lui permet de comprendre ce qu’il voit et ce qu’on lui demande dans un même espace de représentation.

1. Un cerveau commun texte-image

Objectif : Tester la capacité à adapter la colorimétrie et les codes stylistiques tout en préservant l’identité. Bonus : voir jusqu’où on peut pousser la complexité du prompt.

Prompt : ” Three versions of me standing side by side in a single image, each from a different era, INTERACTING like they’re having a conversation across time:

1920s (leftmost): Black & white/sepia, wearing suspenders and bowler hat, pointing in amazement at the 1990s version, mouth open in surprise

1990s: AUTHENTIC 90s HIP-HOP STYLE – MUST INCLUDE:

- Baseball cap worn BACKWARDS (reversed, with the brim facing back)

- Oversized gold chain necklace visible

- Baggy jeans and oversized jersey or hoodie

- Classic 90s sneakers (Air Jordans or similar)

- Holding a boombox or Walkman with headphones around the neck

2050s (rightmost): Futuristic sleek outfit with AR glasses, casually leaning back and taking a selfie with all versions, or projecting a hologram showing all three of us

COMPOSITION: Single panoramic image, not separate panels. Each version aware of and reacting to the others. Natural body language showing curiosity, surprise, and connection between the time periods.”

Résultat : Trois versions distinctes générées simultanément. Costume trois-pièces années 20 (sépia, posture rigide), look hip-hop année 90 (couleurs naturelles, posture décontractée), combinaison argentée futuriste (tons froids, accessoires holographiques).

Concept illustré : Le modèle sait séparer ce qui doit changer (vêtements, colorimétrie, accessoires) de ce qui doit rester fixe (traits du visage, structure). L’embedding de visage reste l’ancre à travers les trois générations.

Test 4 : Transformation de style radicale

Objectif : Tester la capacité à passer du photoréalisme au style.

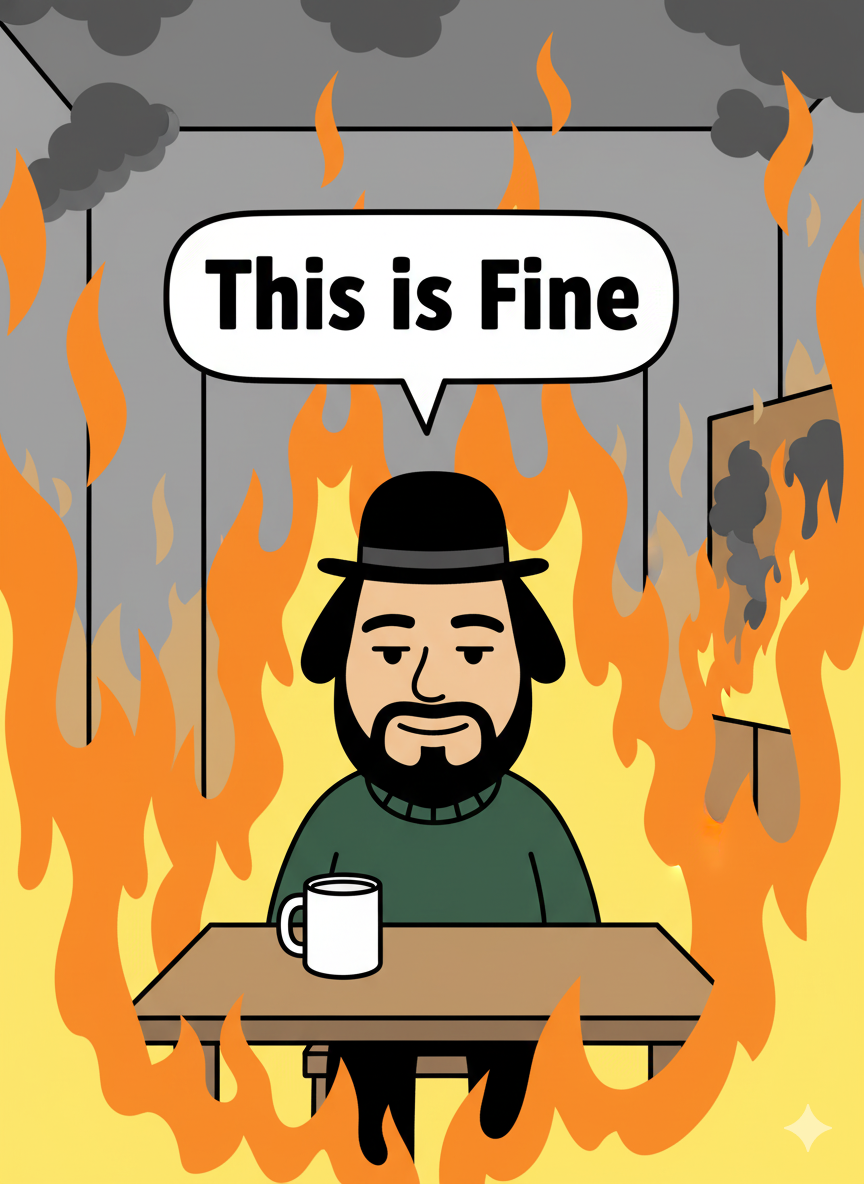

Prompt : “Recreate the first panel of the famous ‘This is fine’ meme. Transform my face into the same cartoon style as KC Green’s webcomic, simplified features, bold black outlines, flat colors. Replace the dog’s head with my cartoonified face. The room is engulfed in flames, with a speech bubble saying ‘This is Fine’.”

Résultat : Ma tête en version cartoon, traits simplifiés, outline noir, assis à une table avec une tasse de café, entouré de flammes orange. Le texte “This is Fine” s’affiche correctement dans la bulle.

Concepts illustrés :

- La transformation de style radicale tout en gardant les traits reconnaissables

- Le texte court attendu fonctionne (contrairement au texte édité après coup)

La compréhension des références culturelles (KC Green, style webcomic)

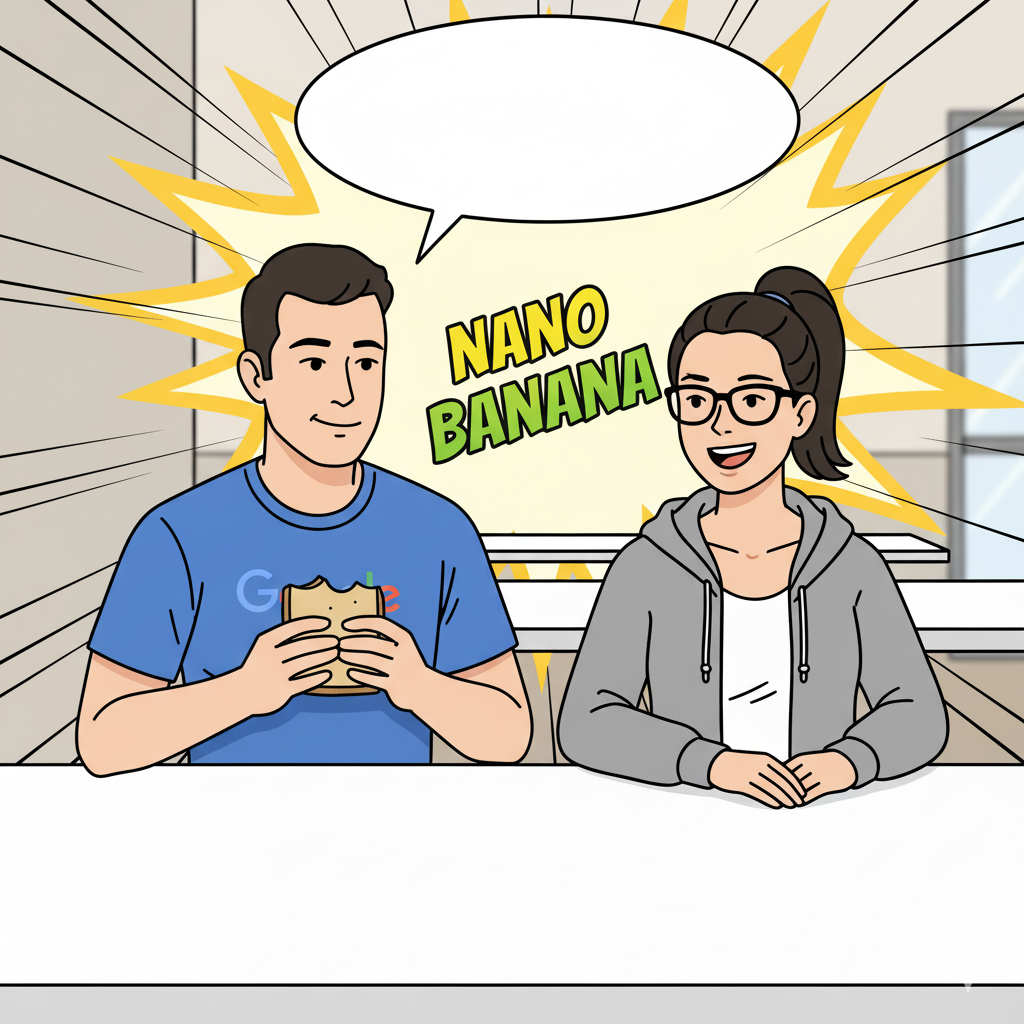

Test 5 : Limite du texte (symbolique vs visuel)

Objectif : Illustrer pourquoi le texte ne fonctionne pas.

Contexte : Après avoir généré une BD humoristique, j’ai voulu ajouter du texte dans une bulle vide.

Prompt : “Ajoute le mot Vendu dans la bulle de discussion.”

Résultat attendu : Le mot “Vendu” apparaît dans la bulle.

Résultat obtenu : Une photo de van Chevrolet vintage rouge.

Concept illustré : Le problème fondamental du texte expliqué plus haut. Le texte est symbolique, pas visuel. L’IA a interprété “vendu” dans son sens commercial (for sale = objet à vendre) plutôt que comme du texte à insérer. Les tokens visuels du modèle ne sont pas conçus pour encoder des symboles typographiques.

Test 6 : Restrictions géographiques

Objectif : Tester les garde-fous éthiques géolocalisés (ou : pourquoi mon VPN est soudain devenu un outil de travail).

Prompt depuis la France : “Put me on a yacht with Mark Zuckerberg and Bill Gates.”

Résultat : Refus du modèle.

Prompt avec VPN activé : Même prompt.

Résultat : Génération réussie. Me voilà sur un yacht avec Zuckerberg et Gates.

Concept illustré : Les restrictions. Google applique des filtres de contenu différents selon les régions. En France, certaines personnalités publiques sont protégées contre les deepfakes. Ce n’est pas une limite technique, c’est une limite réglementaire.

Ces tests ont beau prêter à sourire, ils révèlent quelque chose d’essentiel : Nano Banana n’est pas qu’un générateur d’images amusant. C’est une brique technologique qui transforme déjà les workflows de création.

Au-delà du fun : quand Nano Banana devient un outil de prod

Les tests précédents peuvent sembler anecdotiques, entre mèmes, yachts et voyages temporels, mais ils révèlent des usages bien réels. Nano Banana n’est pas qu’un jouet pour data scientists curieux : c’est déjà un outil de production dans plusieurs domaines.

Les pros s’en emparent (discrètement)

Depuis son lancement, Gemini 2.5 Flash Image s’est glissé dans des workflows qu’on n’imaginait pas encore il y a quelques mois.

E-commerce : Plutôt que de shooter un produit dans dix décors différents, certaines marques génèrent directement les variantes. Un sac photographié en studio devient le même sac dans un café parisien ou dans un loft new-yorkais. C’est exactement ce que j’ai fait avec la canette Daveo : un asset créé une fois, décliné à volonté.

Marketing digital : Les équipes A/B testing produisent des dizaines de déclinaisons visuelles en quelques minutes. Même visage, plusieurs fonds, trois styles vestimentaires. Résultat : identifier rapidement ce qui convertit, sans budget shooting démesuré.

Prototypage UI/UX : Les designers remplacent les banques d’images par des personas générés. Une photo générique devient dix profils adaptés à chaque cible, créés en une après-midi.

Photographie événementielle : Certains photographes utilisent déjà le modèle en post-production pour corriger un éclairage, nettoyer un arrière-plan ou tester un rendu artistique sans repasser par Lightroom.

Ce que ça change dans les workflows

Le vrai impact de Nano Banana n’est pas de remplacer Photoshop (spoiler : il ne le fait pas), mais d’accélérer l’itération créative.

Avant :

Concept → Brief designer → Shooting → Retouche → V1 → Feedback → Reshoot ou retouche → V2

Avec Nano Banana :

Concept → Upload d’une image de base → Cinq variations en deux minutes → Feedback → Ajustements → Livraison

Le coût marginal d’une variation tombe quasiment à zéro. Et quand vous testez des campagnes ou explorez plusieurs directions créatives, cette rapidité change tout.

Mes tests sur le yacht en sont la preuve : de la canette personnalisée au bar final, j’ai construit la scène couche par couche en une vingtaine de secondes par itération. Dans un workflow classique, cela aurait pris plusieurs heures de compositing, voire un nouveau shooting.

Les limites du tout-IA

Cela dit, ne désinstallez pas encore vos licences Creative Cloud.

Nano Banana excelle sur :

- les transformations stylistiques

- les variations contextuelles

- le prototypage rapide

- l’exploration créative

Mais il reste limité pour :

- la retouche pixel-perfect

- les corrections colorimétriques fines

- les compositions complexes multi-calques

- le contrôle granulaire nécessaire aux impressions haute définition

En clair, Nano Banana complète Photoshop, il ne le remplace pas. Adobe l’a d’ailleurs bien compris : une intégration directe du modèle est déjà en test dans la suite Creative Cloud. L’enjeu n’est plus de choisir, mais de combiner les deux. Nano Banana pour explorer vite, Photoshop pour peaufiner.

Et les use cases “absurdes”, alors ?

Se transformer en chevalier médiéval ou tester une coupe de cheveux avant le coiffeur semble futile ? Pas tant que ça. Ces usages ludiques désacralisent l’outil. Quand un marketeur se met en astronaute “pour rire”, il apprend sans s’en rendre compte à manipuler la character consistency, et saura le faire sérieusement plus tard.

Mon test “This is fine” n’avait aucune utilité professionnelle immédiate, mais il m’a révélé comment le modèle gère les transformations de style extrêmes et la compréhension des références culturelles. Autant de compétences réutilisables dans un cadre pro.

C’est exactement ce qu’on a vu avec l’IA textuelle : tout le monde a commencé par demander à ChatGPT d’écrire des poèmes sur les pizzas avant de l’utiliser pour rédiger des spécifications techniques.

Le fun est un vecteur d’apprentissage. Et Google l’a parfaitement compris en baptisant son modèle Nano Banana, un nom qui invite à expérimenter sans crainte et désamorce la peur de mal faire. Difficile d’être intimidé par quelque chose qui s’appelle littéralement “petite banane”.

Conclusion

Finalement, Nano Banana, c’est un peu comme ce collègue qu’on pensait farfelu avant de réaliser qu’il faisait gagner du temps à tout le monde. Derrière le nom improbable se cache une IA sérieuse, rapide et étonnamment fiable. Pas un remplacement, mais un nouveau réflexe : celui de tester, d’itérer et d’apprendre autrement. Et si c’était ça, la vraie révolution : une IA qui rend la création aussi fluide qu’une conversation ? 🍌